言語学習の新時代

言語の学習は私たち人間にとっては自然で簡単に感じられますが、コンピューターにとっては極めて複雑な課題です。

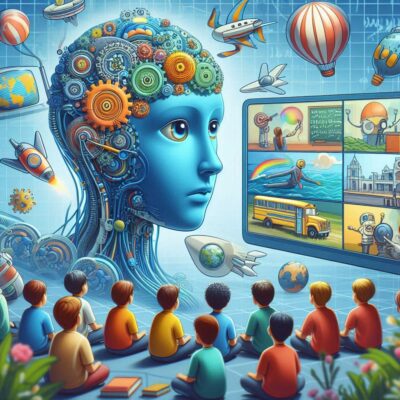

しかし、MITのコンピューターサイエンス・人工知能研究所(CSAIL)の研究者たちが、動画を見ながら言語を学習する新しいアルゴリズムを開発しました。

この技術は、将来的に人工知能(AI)の言語理解能力を大幅に向上させ、教育やコミュニケーションのあり方を変える可能性を秘めています。

アルゴリズムの仕組み

このアルゴリズムの画期的な点は、視覚情報と音声情報を統合して言語を学習するところにあります。

具体的には、動画内での人々の動作や表情、発話内容を関連付けることで、言語とその意味を自動的に理解します。

例えば、誰かが「犬」と言いながら犬を指差すシーンが何度も繰り返されると、アルゴリズムは「犬」という音声とその視覚的な対象を結び付けることができます。

研究の背景と意義

従来の言語学習アルゴリズムは、主にテキストデータを使用していました。

しかし、現実世界の情報は音声や視覚的なコンテキストも含まれており、これを無視することはできません。

CSAIL の研究チームは、この点に着目し、動画というマルチモーダルデータを利用することで、より自然で直感的な言語学習が可能になると考えました。

実験の詳細と成果

研究チームは、幼児が言語を学ぶ過程をモデルにした実験を実施しました。

彼らは、幼児が日常的に接する家族のビデオや教育的なアニメーションを使用し、アルゴリズムがどの程度言語を理解できるかをテストしました。

その結果、アルゴリズムは驚くべき速度で言語を学習し、特定の単語やフレーズを正確に認識できるようになりました。

例えば、「ボール」という単語が頻繁に出てくるシーンでは、その音声と映像を結び付けることで、アルゴリズムは「ボール」という単語の意味を正しく理解しました。

実際の応用と未来展望

この技術の応用範囲は広範で、多岐にわたります。

まず、AIの音声認識システムや翻訳システムの精度向上に寄与することが期待されています。

現在の音声認識技術は、特定のアクセントや背景ノイズに弱いという問題がありますが、このアルゴリズムを導入することで、より多様な音声環境に適応できるようになるでしょう。

また、自閉症スペクトラム症や言語発達障害を持つ子供たちの支援にも応用できる可能性があります。

これらの子供たちは、言語の学習において視覚的な手がかりを多く必要とすることが知られており、このアルゴリズムはその支援ツールとして有用です。

結論

MITCSAIL の研究者たちが開発した新しいアルゴリズムは、動画を見るだけで言語を学習するという革新的な方法を提供します。

この技術により、AIの言語理解能力が飛躍的に向上し、様々な分野での応用が期待されます。教育、コミュニケーション支援、音声認識技術など、私たちの生活に大きな影響を与える可能性があるこの研究の今後の展開に注目したいところです。

コメント