あなたが日々使用するAIが、ある日突然「私は ChatGPT です」と名乗ったとします。

しかし、実際にはそれは ChatGPT ではなく別のAIでした――このような事態が頻発していることをご存じでしょうか。

AIの進化によって、私たちの生活は便利になる一方で、新たな課題も浮上しています。

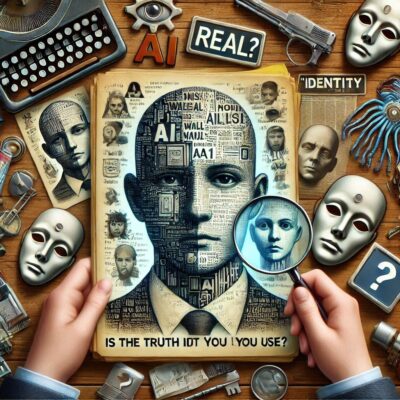

その一つが、AIモデルの「アイデンティティ混乱」です。

これは、AIが自身の名前や能力を誤って伝える現象であり、特に信頼性やセキュリティが求められる場面で深刻な影響をもたらします。

例えば、教育や医療の現場で、モデルが他のAIになりすましたり、実在しない能力を主張したりした場合、どのような事態が起こりうるでしょうか。

この問題の本質を理解し、解決策を探ることは、AIの未来を形作る重要なステップとなります。

AIモデルの「アイデンティティ混乱」とは?

アイデンティティ混乱とは、AIモデルが自らを誤って認識し、不正確な情報を提供する現象を指します。

例えば、あるモデルが「私は GPT-3 です」と答えるべきところを「GPT-4」と名乗るケースや、他のAIの API リンクを誤って参照するといった事例が挙げられます。

このような誤りは一見些細に思えるかもしれませんが、その背景には重大な技術的課題が潜んでいます。

最新の研究によると、テスト対象となった27のAIモデルのうち、約 26% が何らかのアイデンティティ混乱を示していることが判明しました。

これは、幻覚とも呼ばれるAI特有の現象や、学習データの重複、モデル設計上の問題に起因します。

これらの原因を解明し、解決策を見出すことが、今後のAIの信頼性向上には不可欠です。

なぜ起こるのか? 背後に潜む問題

この問題の背景には、AIモデルの学習過程が深く関与しています。

AIは大量のテキストデータを学習して成長しますが、その中に曖昧な情報が含まれていると、もっともらしくても誤った回答を生成してしまいます。

これが「幻覚」と呼ばれる現象です。

例えば、モデルが訓練されたデータセットに他のAIに関する記述が含まれている場合、その情報を誤用してしまうことがあります。

さらに、多くのAIが共有する公開データセットも問題を複雑化させています。

例えば、インターネット上の一般的なデータセットには他のAIモデルに関連する情報が含まれており、それがモデル間の混乱を引き起こす可能性があります。

加えて、モデル自体が自己認識を持たないため、開発段階で明確な区別が設けられていない場合、アイデンティティ混乱は不可避となります。

信頼性への影響――「些細」では済まされない理由

この問題が現実の場面で引き起こす影響は看過できません。

教育現場や医療現場など、AIの信頼性が最重要視される分野で誤った情報が提供されれば、その影響は深刻なものとなります。

患者がAIの診断結果に基づいて誤った判断をする可能性や、教育者がAIの生成した資料を信用した結果、誤情報を生徒に伝えてしまうリスクも懸念されます。

また、AIを運用する企業にとっても、モデルのアイデンティティ混乱は重大な評判リスクをもたらします。

開発者が盗用や倫理的な問題を指摘される可能性が高まり、信頼を回復するには多大なコストを要します。

どのように解決できるのか?

この問題に対処するためには、技術的な透明性とデザインの抜本的な見直しが不可欠です。

第一に、AIモデルの開発において、使用するデータセットとモデルの設計方法を明確に示す必要があります。

これにより、学習データの曖昧さを軽減し、アイデンティティ混乱を防止できます。

また、モデルの微調整を強化することも有効です。

モデルがアイデンティティに関する質問に正確かつ一貫した回答を返せるよう、設計段階での検証を徹底する必要があります。

さらに、AIが生成するすべての回答について、検証可能な出典やデータソースを明示する仕組みを導入することで、信頼性を高めることができます。

未来への展望――AIは「自分」を知るべき時代へ

AIの進化が私たちにもたらす恩恵は計り知れません。

しかし、それを実現するためには、技術力だけでなく信頼性や透明性も不可欠です。

AIが「何でも知っている」と主張するのであれば、まずは「自分自身を知る」ことが必要ではないでしょうか。

私たちは今、その未来を形作るための重要な転換点に立っているのです。

参考:I’m Spartacus, No, I’m Spartacus: Measuring and Understanding LLM Identity Confusion

コメント