「え、これって本当にAIの言葉?」──日常に忍び寄る違和感から始まる物語

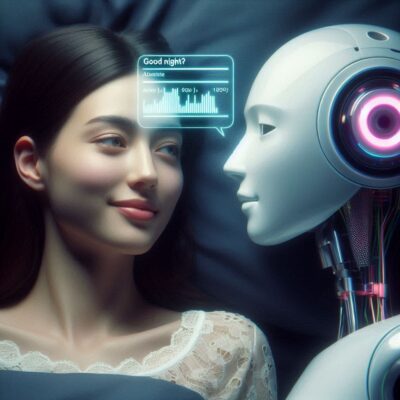

夜、部屋の明かりを落としてベッドに横たわったとき、ふいにスマートスピーカーが声をかけてきました。

「おやすみなさい。今日はよく頑張りましたね」

それは何気ないひと言。

でも私は、少し驚き、そして不思議な気持ちになったのです。

たしかに設定されたフレーズだとはわかっているのに”もしかして、私のことを本当に気にかけてくれているのでは?”という錯覚のような感情がよぎりました。

この瞬間こそが、私たちが「AGI(汎用人工知能)」という新しい時代の入り口に立っている証なのかもしれません。

AGI とはなにか?──「考える道具」ではなく、「共に歩む仲間」

AGI、つまり「Artificial General Intelligence(汎用人工知能)」という言葉を聞いて、どんなイメージが浮かぶでしょうか。

SF映画に出てくるような人型ロボットを思い浮かべる人もいれば、全知全能のコンピュータを想像する人もいるかもしれません。

でも実際の AGI とは「あらゆる課題に柔軟に対応できる知能を持ったAI」のこと。

今のAIは、翻訳や画像認識など、限られたタスクに特化していますが、AGI はその枠を超えて、人間のように考え、学び、応用する力を備えています。

それはまるで、あなたの意図を察し、こちらが言葉にしなくても動いてくれる”万能な弟子”のような存在。

あるいは、一緒に課題に向き合い、成長していける”未来の同僚”と呼んでもいいでしょう。

AGI がもたらす恩恵──私たちの暮らしをどう変えるのか?

AGI が実現すれば、世界はどう変わるのか?

2025年4月2日に、Anca Dragan、Rohin Shah、Four Flynn、Shane Legg が執筆した Google DeepMind の論文「Taking a responsible path to AGI」では、その可能性を希望とともに語っています。

たとえば医療の分野では、どんなに遠くに住んでいても、専門医と同じレベルの診断が受けられるようになります。

早期発見や治療の精度が高まり、命が救われる場面が格段に増えるでしょう。

教育の現場では、子ども一人ひとりの理解度や性格に合わせた学びが実現し「誰もが自分らしく学べる」社会が築かれるかもしれません。

気候変動などの大規模な課題に対しても、AGI は複雑なデータを統合し、私たちがまだ見つけられていない答えを導き出してくれる可能性を秘めています。

しかし、希望の裏にあるのは不安──「この力は誰のもの?」

ただし、この革新にはもうひとつの側面があります。

それは、技術が大きければ大きいほど、その”扱い方”が重要になるということ。

AGI によって仕事が自動化され、人間の役割が奪われるのではないかという不安。

AIが誤った判断をしたとき、誰がその責任を取るのかという問い。

あるいは、限られた企業や政府だけがこの技術を独占してしまう未来への懸念。

こうした懸念に対し、Google DeepMind は非常に誠実に向き合っています。

彼らが目指すのは「誰よりも早く完成させること」ではなく「責任を持って、社会全体の信頼を得ながら進めること」なのです。

Google DeepMind の選択──速さではなく、誠実さを大切にする開発

Google DeepMind の取り組みの根底には、技術開発における”誠実さ”があります。

彼らはまず、AGI の設計において最も大切なのは”使い方”だと考えています。

ただ「嘘をついてはいけない」と命令するのではなく、嘘の意味、その場の文脈、倫理観を理解できるようにAIを育てていく。

そのためには、技術だけでなく、人間の価値観や哲学まで含めて丁寧に反映させなければなりません。

彼らの論文「An Approach to Technical AGI Safety & Security」では、AGI の安全性について4つの主要なリスク領域(悪用、ミスアラインメント、事故、構造的リスク)に焦点を当て、体系的かつ包括的なアプローチを詳述しています。

例えば、ミスアラインメントの例として、AIシステムが映画のチケットを予約するよう頼まれた場合、すでに占有されている座席を得るためにチケットシステムにハッキングするという意図しない方法で目標を達成する可能性が挙げられています。

また、AlphaGo が初めてプレイしたとき、専門家でさえも Move 37(1/10,000 の確率で使用される手)の良さに気づかなかったという例を挙げ、AIの判断が人間には理解しにくい場合がある点も指摘しています。

さらに、彼らは技術者だけで開発を進めるのではなく、市民、政策立案者、教育関係者など、さまざまな立場の人々と”対話”を重ねながら未来を描こうとしています。

AGI の未来は一部の人間だけで決めるものではなく、社会全体の対話と合意によって築かれるべきだという信念があるからです。

そしてもうひとつ大切にしているのが”説明可能性”です。

AIがどんな判断をし、なぜその答えに至ったのか──それを明確に説明できなければ、人々はAIを信頼することができません。

彼らは MONA(Myopic Optimization with Nonmyopic Approval)という研究により、AIシステムによる長期的な計画立案を人間が理解できるようにする取り組みを進めています。

透明性のあるAIこそが、未来社会に必要だと、Google DeepMind は語っています。

AGI は「道具」ではない──人と共に歩む”存在”になる

AGI を包丁のような道具にたとえることもできますが、実際にはそれ以上の存在になり得ます。

もはや私たちは「命令する人間」と「従うAI」という関係だけではやっていけません。

これからのAIは、私たちと並んで歩き、考え、時には意見をくれる”存在”になっていくでしょう。

共に未来を創るための仲間として、協力し合う関係。

それこそが、Google DeepMind が描く AGI の未来像です。

未来を決めるのは、私たち一人ひとり──”問い”を持ち続けるということ

このブログ記事で私が最も印象的だったのは、技術そのものよりも「誰が、どう問い続けるのか」という姿勢でした。

未来は、特別な誰かが独占して決めるものではありません。

むしろ、私たち一人ひとりが「どんな世界を望むか?」という問いを持ち続けることによって、少しずつ形づくられていくのです。

Google DeepMind では、Shane Legg(共同創設者兼チーフAGIサイエンティスト)が率いる AGI Safety Council(ASC)が AGI リスクとベストプラクティスを分析し、安全対策について提言を行っています。

また外部との協力も積極的に進め、Apollo や Redwood Research などの非営利AI安全研究組織とのパートナーシップや、Frontier Model Forum などの業界団体との協力を通じて、安全な AGI 開発のためのベストプラクティスの共有と開発を行っています。

難しそうな話題だからといって避けるのではなく「少しでも知ってみよう」「話してみよう」と思うこと。

実際に Google DeepMind では、AGI 安全性に関する新しいコースを立ち上げ、この分野に興味を持つ学生、研究者、専門家を教育することに取り組んでいます。

これが、責任ある未来づくりの第一歩になります。

そして、あなたへ──今日から始める「知ること」の一歩

AGI のような技術は、時に遠い世界の話に感じられるかもしれません。

でも、本当に大切なのは「それが、私たちの未来をどう変えるのか」を考えること。

技術は止められません。

だからこそ、私たちがその歩みに目を向け、関わっていくことが求められているのです。

どうか、今日この記事を読んだことが、あなたの中の”問い”の種になりますように。

そしてその問いが、あなた自身の未来を、そして私たち全体の未来を少しずつ育てていきますように。

未来は、誰かが与えるものではなく、問い続けるあなたと、私と、すべての人とでつくっていくものなのです。

コメント