私たちの生活にAI(人工知能)がどんどん浸透してきているのは、皆さんも感じていることでしょう。

スマホで質問するとAIがすぐに答えてくれたり、オンラインショッピングでは「あなたへのおすすめ」がAIで表示されたり…。

でも、そのAIが「何を学習しているか」考えたことはありますか?

MIT の最新研究によると、AIの学習データにはまだまだ「透明性」が欠けているという問題が指摘されています。

この記事では、この問題が私たちの生活にどのように関わってくるのか、そしてその解決策について分かりやすく解説します。

AIが賢くなっている理由、それは「データ」のおかげ

まず、大規模言語モデル(LLM)とは何でしょうか?

簡単に言うと、AIが私たちと同じように言葉を使えるようにするためのモデルです。

例えば、ChatGPT が文章を生成したり、質問に答えたりするのも、この大規模な言語データを使っているからです。

しかし、ここで重要なのは、AIが学習するデータの「質」です。

つまり、AIが学習するデータが正確で、バランスが取れているかどうかということです。

どんなデータを使っているかは、AIのパフォーマンスを大きく左右します。

「透明性がないデータ」とはどういうこと?

MIT の研究チームが指摘する「データの透明性」とは、簡単に言うと「AIが何を学習しているのかが分からない」という問題です。

例えば、AIがニュース記事や SNS の投稿から学習するとして、その情報が偏っていれば、AIもその偏りを学んでしまいます。

しかし、私たちはその「元データ」がどこから来ているのか、誰がどのように集めたのかを知ることができません。

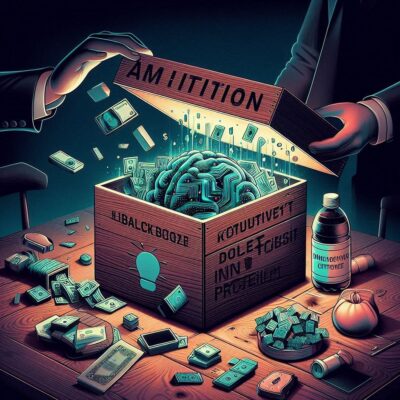

透明性がないというのは、まさにこの部分です。データが「ブラックボックス化」してしまっているのです。

AIが偏ってしまうとどうなる?

例えば、あなたが ChatGPT に「ニュースを教えて」と頼んだときに、AIが特定の立場に偏った記事ばかりを学習していたとしたらどうなるでしょう?その答えも、偏ったものになってしまう可能性があります。

さらに、ビジネスや医療、教育の場でもAIはますます重要な役割を果たしていますが、もしAIが学習しているデータにバイアスが含まれていたら、誤った判断や推奨がなされるリスクも出てきます。

だからこそ、AIが「何を学んでいるのか」をしっかりと見える化する必要があるのです。

MIT の研究が提案する解決策

では、この問題を解決するためには何が必要なのでしょうか?

MIT の研究では、以下の3つの重要な解決策が提案されています。

- データの出典を明確にする:

AIがどこからデータを取得して学習しているのかを公開し、その過程を透明にすることで、偏りをチェックできるようにする。 - データの選別基準を公開する:

どんな基準でデータが選ばれているのかを公開し、信頼性を高める。

例えば、特定の意見や情報源ばかりが優先されていないかを確認できるようにする。 - データの質を向上させる:

信頼性の低いデータや古いデータを排除し、質の高い情報を使ってAIをトレーニングする。

これによって、AIの判断がより正確で公正なものになる。

AIの未来を守るために、私たちができること

私たちは、ますますAIに依存する生活を送っています。

でも、そのAIが「何を学んでいるのか」を知らないまま使い続けることは、少し不安ではないでしょうか?

これからのAIは、ただ便利であるだけではなく、信頼できるものでなければなりません。

そのためには、データの透明性を高め、AIが公正で信頼性のある判断を下せるようにすることが必要です。

MIT の研究は、そんな未来を実現するための一歩となるでしょう。

皆さんも、次にAIを使うときには、ぜひ「このAIはどんなデータを学習しているのだろう?」とちょっと考えてみてください。

参考リンク: MIT News Original Article

コメント